近年、AI技術の発展は目覚ましく、Webサイト上のありとあらゆる情報が自動収集され、学習するAIクローラーが増加しています。これにより、WordPressサイトのコンテンツも、意図せず学習データとして利用されるリスクが高い傾向です。

この状況を放置すると、自身のサイトが持つ独自性や専門性が薄れるだけでなく、ブランドイメージの低下や検索エンジンからの評価下落に繋がりかねません。

あなたのコンテンツを守り、サイトの価値を維持するには、AI学習を禁止するための対策を講じる必要があります。

この記事では、WordPressサイトをAI学習させないための対策を詳しく解説します。

AIがWordPressサイトを学習する仕組みが知りたい方、AI学習を防ぐための設定方法を把握したい方は、ぜひ最後までお読みください。

目次

WordPressテーマ「GLUE」

無料で高機能なWordPressテーマが手に入る。AIがWordPressサイトを学習する仕組み

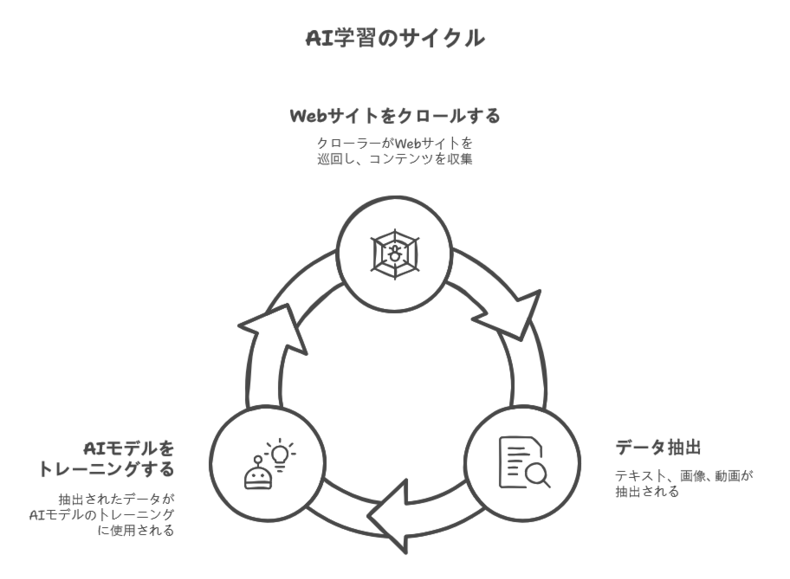

AIがWebサイトを学習する仕組みは、クローラーがインターネット上のサイトを巡回し、公開されているコンテンツを自動的に収集することから始まります。

AIクローラーは、Googleの検索エンジンがWebサイトをインデックスするために使うクローラーと同様の技術をベースにしています。学習用データセットとして利用する情報は、以下のとおりです。

- テキスト

- 画像

- 動画

これらのデータを抽出し、AIモデルとしているわけです。

たとえば「ChatGPT」のような大規模言語モデル(LLM)は、膨大なWeb上のテキストデータを学習し、自然な文章を生成する能力を備えています。

ChatGPT

AIクローラーはWebサイトに設置されているファイル「robots.txt」を最初に読み込み、サイト管理者が定めたアクセスルールに従います。関する記述がなければ、クローラーはサイト内の情報を自由に収集するのが一般的です。

したがって、AIに学習されたくないコンテンツがあるサイト運営者は、クローラーのアクセスを意図的に制限しなければいけません。

AIに勝手に学習されたくないと感じる人は多い

WordPressサイトの運営者で、AIにコンテンツを勝手に学習されたくないと感じる方は少なくありません。

その背景には、時間をかけて執筆したオリジナルのコンテンツがAIによって学習され、生成された類似コンテンツが世に溢れる不満が挙げられます。これが現実になると、自社のサイトの独自性やブランド価値が損なわれる可能性が高まるでしょう。

もっといえば、コンテンツがAIによって別のサイトで再構築された場合、あなたのコンテンツがコピーコンテンツと認識され、検索順位が下落するリスクもあります。

また、AI学習の是非や著作権に関する法整備がまだ追いついていない現状も、運営者の不安を煽る一因です。自身のコンテンツがどのような形でAI学習に利用されるのか、それが商業的に悪用されるのではないかなど、倫理的な問題も多くの人々が懸念しています。

これらの理由から、コンテンツの著作権やサイトのパフォーマンス、ブランド価値を守るために、AI学習を積極的に阻止したいと考える方は珍しくありません。

WordPressサイトがAI学習されないための対策と手順

WordPressサイトがAI学習されないための対策は、大きく分けると3つあります。

- robots.txtでAIクローラーのアクセスを禁止する方法

- .htaccessでAIクローラーのアクセスを禁止する方法

- functions.phpでAIのアクセスに404を返す方法

それぞれ詳しく見ていきましょう。

robots.txtでAIクローラーのアクセスを禁止する方法

AIクローラーのアクセスを禁止する一般的な方法には、robots.txtファイルを編集し、AIクローラーの動作を禁止する方法があります。

robots.txtは検索エンジンのクローラーに対して、どのページをクロールしてよいか、どのページをクロールしてはいけないかを指示するためのファイルです。

AIクローラーのユーザーエージェントを指定し、サイト全体または特定のディレクトリへのアクセスを禁止するルールを記述すれば、コンテンツの収集を停止できます。

それででは、robots.txtでAIクローラーのアクセスを禁止する手順を解説します。

①:robots.txtに指示を書き込む

robots.txtにAIクローラーのアクセスを禁止する指示を書き込む際は、まずメモ帳をなどのテキストエディタ

開き「robots.txt」というファイルを作成します。

ファイル内には、アクセスを禁止したいAIクローラーのユーザーエージェント名を指定します。主要エージェントからの学習を禁止したい場合の指示は、以下のとおりです。

User-agent: GPTBot Disallow: / User-agent: ChatGPT-User Disallow: / User-agent: Google-Extended Disallow: / User-agent: anthropic-ai Disallow: / User-agent: Claude-Web Disallow: / User-agent: CCBot Disallow: /

OpenAIのGPTBotをブロックしたい場合は「User-agent: GPTBot」と記述しましょう。特定のユーザーエージェントに対し、サイト全体へのアクセスを禁止したい場合は、当該ユーザーエージェントの後に「Disallow: /」という指示を追加してください。

これにより、AIクローラーはrobots.txtを読み込んだ際に、サイトへのアクセスを停止します。

②:サーバーに設置する

robots.txtが完成したら、WordPressサイトが設置されているサーバーのルートディレクトリにアップロードします。

WordPressサイトのURLが「https://example.com/」の場合、robots.txtファイルは「https://example.com/robots.txt」としてアクセスできるように配置してください。

エックスサーバーの場合、public_htmlフォルダ内にファイルを置きます。

場所が間違っていると、クローラーがrobots.txtファイルを認識できないため、アクセスを禁止できません。サーバーのファイルマネージャー機能を利用して、正しくアップロードできているか確認しましょう。

.htaccessでAIクローラーのアクセスを禁止する方法

AIクローラーのアクセスを確実に制御したい場合は、.htaccessファイルの利用が有効です。

.htaccessファイルはサーバーの動作を制御するための設定ファイルのため、特定のユーザーエージェントからのアクセスを物理的にブロックできます。

先ほど紹介した「robots.txt」は、あくまでクローラーへのリクエストにすぎません。したがって、指示に従わないケースも考えられます。

WordPressサイトをAI学習から完全に制御したいなら、.htaccessでアクセス自体を拒否しましょう。

ここでは、具体的な手順を詳しく解説します。

①:サーバー上の.htaccessにアクセスする

.htaccessファイルを編集するには、WordPressサイトが設置されているサーバー上の「.htaccess」ファイルにアクセスする必要があります。

サーバーのファイルマネージャーから、WordPressをインストールしているディレクトリ(ルートディレクトリ)にアクセスし、ファイルを編集(右クリックするなどしてメニューから「編集」を選ぶ)してください。

編集作業を始める前に、既存の.htaccessファイルのバックアップを忘れずに取っておいてください。

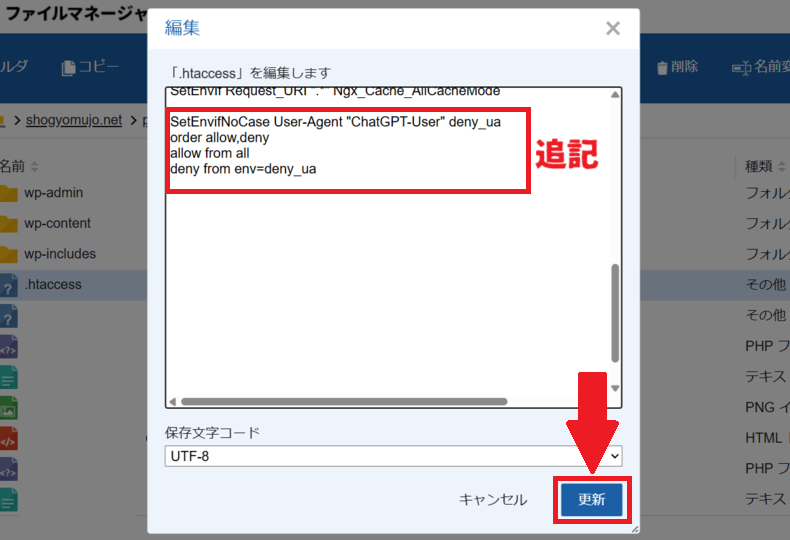

②:.htaccessに指示を追記する

.htaccessファイルにAIクローラーのアクセスを禁止する指示を追記する際は、特定のユーザーエージェントからのアクセスを拒否するコードを追記します。

たとえば、ChatGPTのクローラーをブロックする場合の記述は以下のとおりです。

SetEnvifNoCase User-Agent "ChatGPT-User" deny_ua order allow,deny allow from all deny from env=deny_ua

※最終行は1行空行が必要なので注意!

.htaccessファイルに書かれている記述の下に、このように追記して「更新」してください。

以上で完了です。

functions.phpでAIのアクセスに404を返す方法

WordPressサイトがAIクローラーによって学習されるのを禁止するには、functions.phpファイルを編集し、AIのユーザーエージェントからのアクセスに対し「404 Not Found」を返す方法もあります。

これはAIクローラーがサイトにアクセスした際に、そのページが存在しないと認識させ、コンテンツの収集を阻止する手段です。

「robots.txt」の指示に従わないクローラーや「.htaccess」の設定が難しく困難な場合に有効な方法といえるでしょう。ただし、WordPressのテーマファイルに直接書き込むため、更新によって内容が上書きされる可能性があります。

ここでは、具体的な手順を詳しく解説します。

①:WordPressの管理画面からfunctions.phpにアクセスする

functions.phpファイルにアクセスするには、WordPressの管理画面から「外観」>「テーマファイルエディター」に進み、現在使用しているテーマの「functions.php」を編集します。

子テーマがある場合は、子テーマのfunctions.phpを編集してください。

なお、サーバーのファイルマネージャーからも編集は可能です(「wp-content/themes/使用中のテーマ名/」のディレクトリ内)。

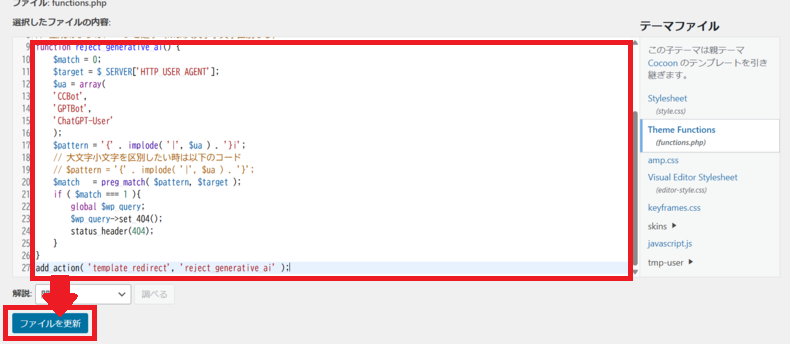

②:functions.phpに指示を追記する

functions.phpにAIクローラーのアクセスに404を返す指示を追記する際は、以下のような記述をします。

// AIクローラーに対して404ページを返す

function reject_generative_ai() {

$match = 0;

$target = $_SERVER['HTTP_USER_AGENT'];

$ua = array(

'CCBot',

'GPTBot',

'ChatGPT-User'

);

$pattern = '{' . implode( '|', $ua ) . '}i';

// 大文字小文字を区別したい時は以下のコード

// $pattern = '{' . implode( '|', $ua ) . '}';

$match = preg_match( $pattern, $target );

if ( $match === 1 ){

global $wp_query;

$wp_query->set_404();

status_header(404);

}

}

add_action( 'template_redirect', 'reject_generative_ai' );

上記は、CCBot、GPTBot、ChatGPTに対して制御しています。その他エージェントにも404を返す場合は「$ua = array(」の下に、制限を加えたいエージェント名を加えて行ってください。

$ua = array(

'CCBot',

'GPTBot',

'ChatGPT-User',

'Google-Extended',

'Claude-Web'

);

記述を加えたら「ファイルを更新」をクリックしてください。

これにより、以降は関数内でAIクローラーのユーザーエージェント名が随時チェックされ、一致した場合には「ページが存在しない(404)」と返すことができます。

robots.txtが表示されない場合の対策

WordPressサイトでrobots.txtファイルを編集し、アップロードしたにもかかわらず、ブラウザで確認すると表示されなかったりエラーが出たりする場合があります。

これはサーバー設定や、ファイル自体の問題が原因です。

robots.txtが正しく動作しないと、意図したクローラーの制御ができないため、403エラーや404エラーが表示される場合は適切に設定されているか確認する必要があります。

ここでは、それぞれの対策を詳しく解説します。

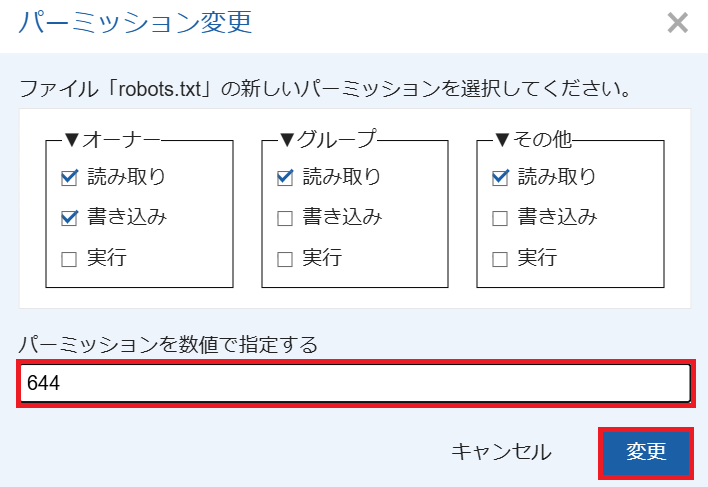

403エラーが表示される場合

robots.txtファイルにアクセスした際に、403 Forbiddenエラーが表示される場合は、ファイルのパーミッション(権限設定)が正しくない可能性があります。

サーバー上のファイルは、誰が読み取り、書き込み、実行できるかをパーミッションで設定しています。robots.txtはクローラーが読み取れるよう設定する必要があるため、一般的には「644」や「604」などのパーミッションに設定するべきです。

サーバーのファイルマネージャーからファイルにアクセスしたら、パーミッションを644に設定しましょう。

「変更」をクリックすれば完了です。

404エラーが表示される場合

robots.txtファイルにアクセスした際に「404 Not Found」エラーが表示される場合は、ファイルがサーバーの正しい場所にアップロードされていない可能性が高いです。

robots.txtは、WordPressサイトのルートディレクトリに配置しなければいけません。サブディレクトリに配置していたり、ファイル名が間違っていたりすると、クローラーはファイルを見つけられないため注意が必要です。

サーバーのファイルマネージャーを使用し、ルートディレクトリに正しく存在しているか、ファイル名がrobots.txtになっているか、再確認してください。

まとめ

WordPressサイトのAI学習を禁止するには、robots.txt、.htaccess、functions.phpを編集する方法が有効です。これらを適切に実施すれば、安心してサイトを運営できるでしょう。

ただし、それぞれを実施する際は事前にファイルのバックアップを取るほか、検索エンジンのクローラーを誤ってブロックしないよう注意が必要です。

WordPressテーマ「GLUE」

無料で高機能なWordPressテーマが手に入る。

コメント